2025-07-07 | 阅读(77)

SpringBoot Web 项目要支持响应数据的自动压缩只需要在 application.properties 中配置 server.compression.enabled=true 即可,默认为 false. 这样对于默认 server.compression.min-response-size=2KB 达到 2KB 大小的响应,并且请求头中有 Accept-Encoding: gzip 或 deflate 就会压缩响应数据。

相关的配置请参考:SpringBoot Server Properties

- server.compression.enabled: 默认为 false

- server.compression.excluded-user-agents: 针对哪些 user-agents(逗号分隔) 不压缩,默认为空

- server.compression.mime-types: 会对哪些响应的 content-type 进行压缩,默认为 text/html, text/xml, text/plain, text/css, text/javascript, application/javascript, application/json, application/xml

- server.compression.min-response-size: 默认为 2KB

文本数据压缩比可达到百分之七八十,对于节约网络消耗来说是非常可关的,不过要些许 CPU 资源。说完了响应的自动压缩,如果请求数据较大也应考虑对请求进行压缩。比如客户端发送请求时带上 Content-Encoding:gzip, 并且请求内容是 gzip 压缩的。

提示:如果 SpringBoot Web 是放在 AWS API Gateway 后端,那么 AWS API Gateway 会在看到请求头 Content-Encoding 的值为 gzip, compress, deflate, 或 br, 会自动解压缩请求数据,然后转发解压缩后的数据到后端,这时候 SpringBoot Web 无需进行请求数据的解压处理。不过对响应数据的压缩是 SpringBoot Web 要做的,AWS API Gateway 并无该功能。

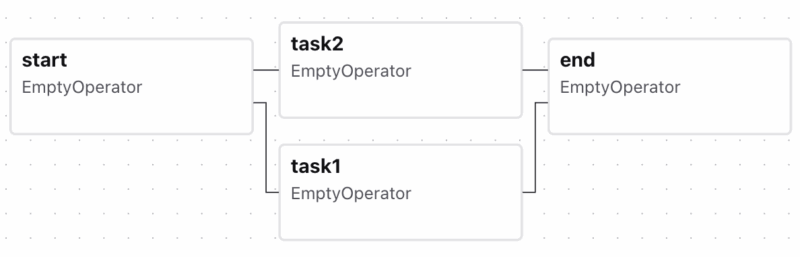

SpringBoot 默认不支持自动解压缩请求内容,如果手动在 Controller 方法中,可以接收字节数组,然后自行解压缩。比如定义如下的 Controller 方法 阅读全文 >>