今天继续探讨 CompletableFuture 的特性,它并发时的性能如何呢?我们知道集合的 stream() 后的操作是序列化进行的,parallelStream()是能够并发执行的,而用 CompletableFuture 可以更灵活的控制并发。

我们先可以对比一下 parallelStream() 与 CompletableFuture 的性能差异

假设一个这样的耗时 1000 毫秒的计算任务

|

1 2 3 4 5 6 7 |

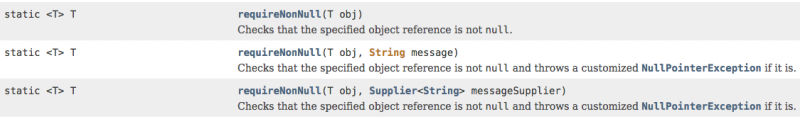

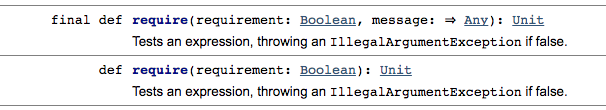

private static int getJob() { try { Thread.sleep(1000); } catch (InterruptedException e) { } return 50; } |

分别用下面两个方法来测试,任务数可以通过参数来控制 阅读全文 >>